- 今天给大家介绍以色列本·古里安大学的研究人员发表在NIPS2020上的一篇论文。图卷积网络(GCN)在处理无序数据(如点云和网格)方面已被证明是有效的方法,作者在有限差分和代数多重网格框架的启发下,提出了用于图卷积,池化和解池化的新颖方法——DiffGCN,经各种实验证明,DiffGCN拥有最好的结果。 介绍 过去的几年中,许多工作使用标... 今天给大家介绍以色列本·古里安大学的研究人员发表在NIPS2020上的一篇论文。图卷积网络(GCN)在处理无序数据(如点云和网格)方面已被证明是有效的方法,作者在有限差分和代数多重网格框架的启发下,提出了用于图卷积,池化和解池化的新颖方法——DiffGCN,经各种实验证明,DiffGCN拥有最好的结果。 介绍 过去的几年中,许多工作使用标...

- @Author:Runsen Faster R-CNN 由于Fast R-CNN 过程中仍然存在一个瓶颈,即ROI Projection。众所周知,检测对象的第一步是在对象周围生成一组潜在的边界框。在 Fast R-CNN 中,ROI Projection是使用Selective Search创建的,发现一个非常缓慢的过程是整个对象检测过程的瓶颈。 选择性搜索是一... @Author:Runsen Faster R-CNN 由于Fast R-CNN 过程中仍然存在一个瓶颈,即ROI Projection。众所周知,检测对象的第一步是在对象周围生成一组潜在的边界框。在 Fast R-CNN 中,ROI Projection是使用Selective Search创建的,发现一个非常缓慢的过程是整个对象检测过程的瓶颈。 选择性搜索是一...

- @Author:Runsen 本文博客目标:了解自动编码器的基本知识 参考文献 https://blog.keras.io/building-autoencoders-in-keras.html https://medium.com/@curiousily/credit-card-fraud-detection-using-autoencoders-in... @Author:Runsen 本文博客目标:了解自动编码器的基本知识 参考文献 https://blog.keras.io/building-autoencoders-in-keras.html https://medium.com/@curiousily/credit-card-fraud-detection-using-autoencoders-in...

- 一,model文件解释 yolov5的模型配置文件如下: # parametersnc: 80 # number of classesdepth_multiple: 1.0 # model depth multiplewidth_multiple: 1.0 # layer channel multiple # anchorsanchors: - [10,13,... 一,model文件解释 yolov5的模型配置文件如下: # parametersnc: 80 # number of classesdepth_multiple: 1.0 # model depth multiplewidth_multiple: 1.0 # layer channel multiple # anchorsanchors: - [10,13,...

- 系列内容深度学习CNN 文章目录 CNN网络架构图展示的卷积神经网络:卷积神经网络的层结构和全连接神经网络的层结构不同:卷积计算池化全连接 CNN网络架构 一个卷积神经网络由若干卷积层、Pooling层、全连接层组成。你可以构建各种不同的卷积神经网络,它的常用架构模式 INPUT -> [[CONV]*N -> POOL?]*M ... 系列内容深度学习CNN 文章目录 CNN网络架构图展示的卷积神经网络:卷积神经网络的层结构和全连接神经网络的层结构不同:卷积计算池化全连接 CNN网络架构 一个卷积神经网络由若干卷积层、Pooling层、全连接层组成。你可以构建各种不同的卷积神经网络,它的常用架构模式 INPUT -> [[CONV]*N -> POOL?]*M ...

- 原文:深度学习技术前沿 【CV中的Attention机制】基于SENet的改进-SKNet https://github.com/pppLang/SKNet/blob/master/sknet.py 论文地址:https://arxiv.org/abs/1903.06586 caffe: 代码地址:https://github.com/impl... 原文:深度学习技术前沿 【CV中的Attention机制】基于SENet的改进-SKNet https://github.com/pppLang/SKNet/blob/master/sknet.py 论文地址:https://arxiv.org/abs/1903.06586 caffe: 代码地址:https://github.com/impl...

- cnn中关于平均池化和最大池化的理解 接触到pooling主要是在用于图像处理的卷积神经网络中,但随着深层神经网络的发展,pooling相关技术在其他领域,其他结构的神经网络中也越来越受关注。一个典型的卷积神经网络结构图,其中的卷积层是对图像的一个邻域进行卷积得到图像的邻域特征,亚采样层就是使用pooling技术将小邻域内的特征点整合得到新的特征。 &nb... cnn中关于平均池化和最大池化的理解 接触到pooling主要是在用于图像处理的卷积神经网络中,但随着深层神经网络的发展,pooling相关技术在其他领域,其他结构的神经网络中也越来越受关注。一个典型的卷积神经网络结构图,其中的卷积层是对图像的一个邻域进行卷积得到图像的邻域特征,亚采样层就是使用pooling技术将小邻域内的特征点整合得到新的特征。 &nb...

- 原文地址: RetinaFace: Single-stage Dense Face Localisation in the Wildarxiv.org 源码地址: https://github.com/deepinsight/insightface/tree/master/RetinaFace 参考代码 https://github... 原文地址: RetinaFace: Single-stage Dense Face Localisation in the Wildarxiv.org 源码地址: https://github.com/deepinsight/insightface/tree/master/RetinaFace 参考代码 https://github...

- 整体嵌套的边缘检测: Holistically-Nested Edge Detection vgg16: https://github.com/harsimrat-eyeem/holy-edge c++版的: https://github.com/harsimrat-eyeem/hed ... 整体嵌套的边缘检测: Holistically-Nested Edge Detection vgg16: https://github.com/harsimrat-eyeem/holy-edge c++版的: https://github.com/harsimrat-eyeem/hed ...

- darknet:网络挺快,但是权重比较大,占用内存比较多 darknet53 512 p100 gpu 15ms ShuffleNetV2 512 p100 gpu 15ms,但是权重比较小,占用内存小。 dla_34 p100 512 512 23ms 训练比较慢 if __n... darknet:网络挺快,但是权重比较大,占用内存比较多 darknet53 512 p100 gpu 15ms ShuffleNetV2 512 p100 gpu 15ms,但是权重比较小,占用内存小。 dla_34 p100 512 512 23ms 训练比较慢 if __n...

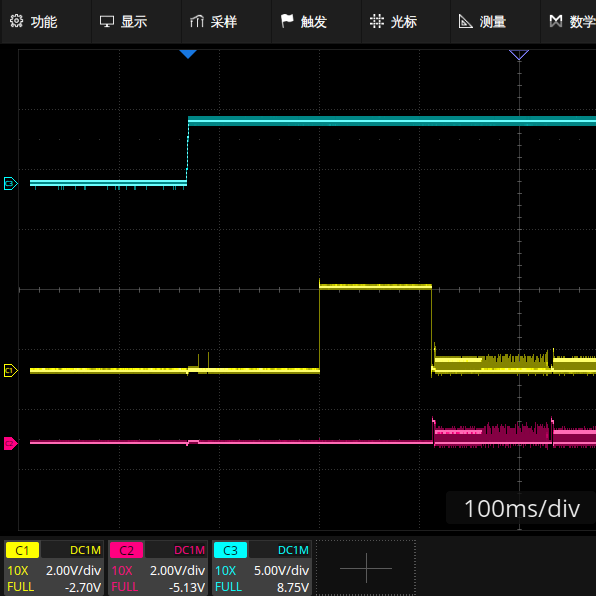

- 结果分布:左边是正样本,右边是负样本。 正负loss要均衡,负样本开始略站优势 左边是正样本,右边是负样本 正确姿势: 先调小学习率,再慢慢加大,因为负样本多,慢慢找正样本。 开始负样本可以在0.8-1之间,占比0.003以内,网络好的话后面就没有了。 先负样本收敛,再正样本收敛 学习率太大的表现: 正负样本两边... 结果分布:左边是正样本,右边是负样本。 正负loss要均衡,负样本开始略站优势 左边是正样本,右边是负样本 正确姿势: 先调小学习率,再慢慢加大,因为负样本多,慢慢找正样本。 开始负样本可以在0.8-1之间,占比0.003以内,网络好的话后面就没有了。 先负样本收敛,再正样本收敛 学习率太大的表现: 正负样本两边...

- https://www.maixj.net/ict/float16-32-64-19912 float16/32/64对神经网络计算的影响 神经网络的计算,或者说深度学习的计算,全都是浮点数。浮点数的类型分16/32/64(128位的不再考虑范围内,numpy和python最大只到float64),选择哪一种浮点数类型,对神经网络的计算有不同的影响。以下是... https://www.maixj.net/ict/float16-32-64-19912 float16/32/64对神经网络计算的影响 神经网络的计算,或者说深度学习的计算,全都是浮点数。浮点数的类型分16/32/64(128位的不再考虑范围内,numpy和python最大只到float64),选择哪一种浮点数类型,对神经网络的计算有不同的影响。以下是...

- opencv 调onnx https://github.com/Star-Clouds/CenterFace/blob/master/prj-python/centerface.py ncnn调,比如: https://github.com/moli232777144/mtcnn_ncnn/tree/master/src opencv 调onnx https://github.com/Star-Clouds/CenterFace/blob/master/prj-python/centerface.py ncnn调,比如: https://github.com/moli232777144/mtcnn_ncnn/tree/master/src

- 你的模型到底有多少参数,每秒的浮点运算到底有多少,这些你都知道吗?近日,GitHub 开源了一个小工具,它可以统计 PyTorch 模型的参数量与每秒浮点运算数(FLOPs)。有了这两种信息,模型大小控制也就更合理了。 其实模型的参数量好算,但浮点运算数并不好确定,我们一般也就根据参数量直接估计计算量了。但是像卷积之类的运算,它的参数量比较小,但是运算量非常... 你的模型到底有多少参数,每秒的浮点运算到底有多少,这些你都知道吗?近日,GitHub 开源了一个小工具,它可以统计 PyTorch 模型的参数量与每秒浮点运算数(FLOPs)。有了这两种信息,模型大小控制也就更合理了。 其实模型的参数量好算,但浮点运算数并不好确定,我们一般也就根据参数量直接估计计算量了。但是像卷积之类的运算,它的参数量比较小,但是运算量非常...

- KNN、MOG2和GMG 好像能判断物体移开,花屏效果不好,mouse也不能检测。 mog2: # coding:utf-8 import cv2 # 获取摄像头对象cap = cv2.VideoCapture(0)# 背景分割器对象mog = cv2.createBackgroundSubtractorMOG2() while True: ret, f... KNN、MOG2和GMG 好像能判断物体移开,花屏效果不好,mouse也不能检测。 mog2: # coding:utf-8 import cv2 # 获取摄像头对象cap = cv2.VideoCapture(0)# 背景分割器对象mog = cv2.createBackgroundSubtractorMOG2() while True: ret, f...

上滑加载中

推荐直播

-

HDC深度解读系列 - Serverless与MCP融合创新,构建AI应用全新智能中枢

HDC深度解读系列 - Serverless与MCP融合创新,构建AI应用全新智能中枢2025/08/20 周三 16:30-18:00

张昆鹏 HCDG北京核心组代表

HDC2025期间,华为云展示了Serverless与MCP融合创新的解决方案,本期访谈直播,由华为云开发者专家(HCDE)兼华为云开发者社区组织HCDG北京核心组代表张鹏先生主持,华为云PaaS服务产品部 Serverless总监Ewen为大家深度解读华为云Serverless与MCP如何融合构建AI应用全新智能中枢

回顾中 -

关于RISC-V生态发展的思考

关于RISC-V生态发展的思考2025/09/02 周二 17:00-18:00

中国科学院计算技术研究所副所长包云岗教授

中科院包云岗老师将在本次直播中,探讨处理器生态的关键要素及其联系,分享过去几年推动RISC-V生态建设实践过程中的经验与教训。

回顾中 -

一键搞定华为云万级资源,3步轻松管理企业成本

一键搞定华为云万级资源,3步轻松管理企业成本2025/09/09 周二 15:00-16:00

阿言 华为云交易产品经理

本直播重点介绍如何一键续费万级资源,3步轻松管理成本,帮助提升日常管理效率!

回顾中

热门标签